記事公開日

【AIエージェント開発効率化】AI Toolkit for Visual Studio Codeの概要解説!

この記事のポイント

この記事では、VS Code上でAI開発を完結させる拡張機能「AI Toolkit for Visual Studio Code」に焦点を当て、その機能と開発の流れを紹介します。

- AI Toolkitとは:

モデルの選定からテスト、エージェント構築までをVS Code上で行える、開発者向けのAIエージェント構築キットです。 - ローカルモデルの活用:

「セキュリティ・コスト・速度」に優れた、自分のPC内だけで動くローカルモデルを簡単に構築できます。 - これからの開発スタイル:

「Playground」での試行錯誤から、実装コードの自動生成まで、AI実装のステップがより身近になります。

こんにちは!DXソリューション営業本部の大和矢です。

AIアプリの開発というと、これまでは「クラウド環境を契約して、APIキーを管理して……」という準備が必要でしたが、最近はその流れが少しずつ変わってきているようです。

今回は、VS Codeの拡張機能「AI Toolkit for Visual Studio Code」についてご紹介します。

「最新のAIモデルを手軽に試してみたい」

「機密データの関係で、できればローカル環境でAIを動かしたい」

そんなニーズに応えるツールとして、Microsoftから提供されているこの「AI Toolkit for Visual Studio Code」。

まだ私も触り始めたばかりですが、今後の開発ワークフローを大きく変えてくれそうな予感がしています。

AI Toolkit:数多のモデルにアクセスできる「窓口」

AI Toolkitをインストールすると、まずそのモデルカタログの豊富さに驚かされます。

Microsoft Foundryと同様のモデルカタログに加えて、ローカルモデル(Ollama/ONNX)、さらに「カスタムモデル(BYOM)」の総和ですね。

CaludeやGeminiといった主要なモデルはもちろん、MetaのLlamaや、Microsoftが開発する軽量モデル「Phi-4」などのモデルがリストアップされています。

Microsoft Foundryと接続設定を行えば、左側メニューの「MY RESOURCES」に、すでにクラウド環境へデプロイ済みのモデルが表示され、VS Codeから直接利用可能になります。

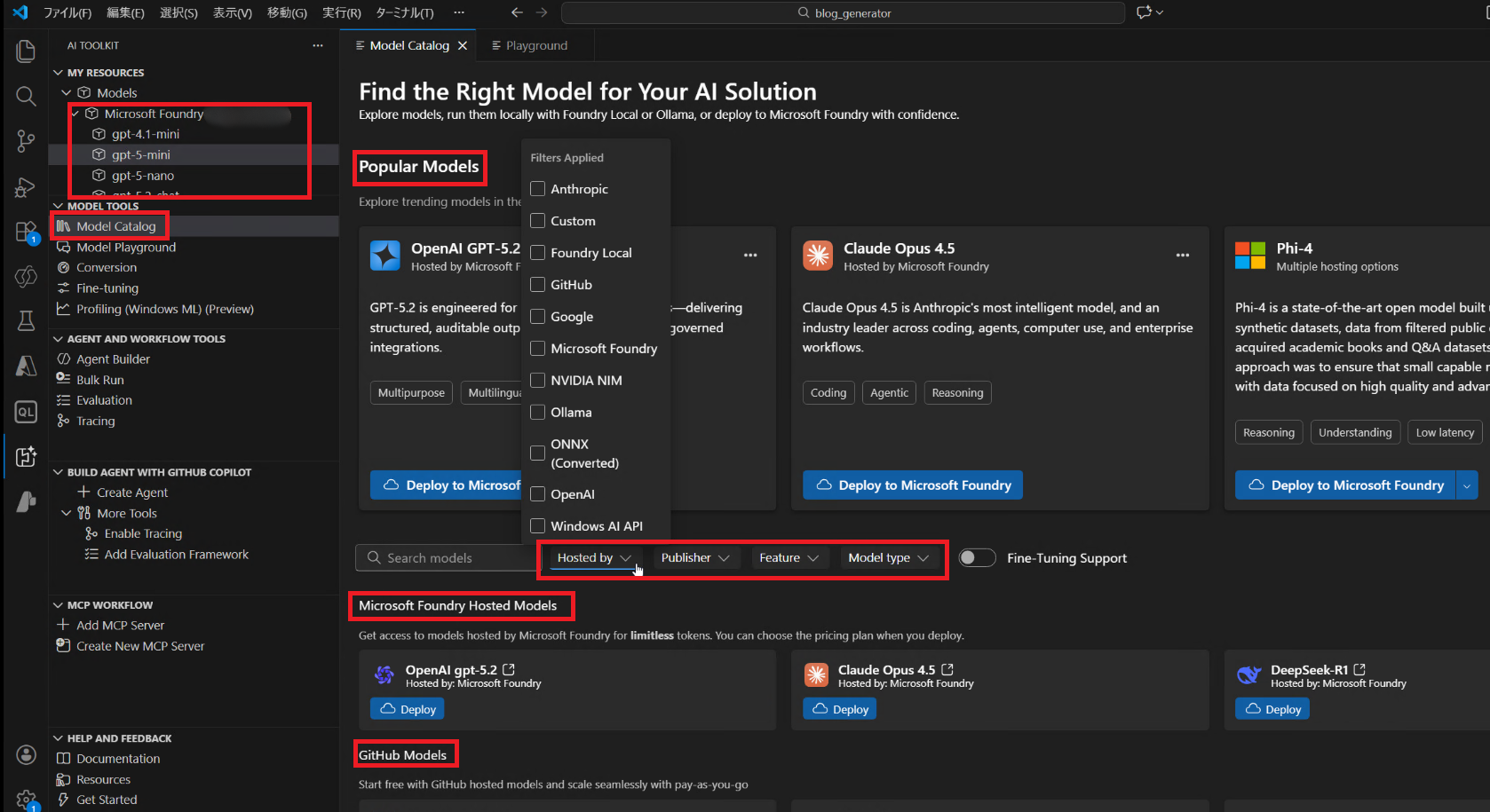

また、左メニューの「Model Catalog」を選択すると、以下のようにモデル一覧が表示されます。

このカタログ機能が便利で、「Hosted by(モデルがどこでホストされているか、例:Microsoft Foundry)」や「Publisher(モデルを開発・公開している企業や組織、例:Microsoft)」、「Feature(機能)」などで細かくフィルタリングが可能です。

そもそも「ローカルモデル」って何?

ここで少し、AI Toolkitがサポートしている「ローカルモデル」について触れておきたいと思います。

「クラウドのエージェントと何が違うの?」と思われるかもしれませんが、簡単に言うと「自分のPC(ローカル環境)の中だけで完結して動くAI」のことです。

これまではAIといえばクラウド上のLLMを使うのが一般的でしたが、最近は自分の端末だけで動くモデルも注目されています。

💡 ローカルモデルの3つのメリット

- セキュリティ:

入力したデータがPCの外に出ないため、社外秘のドキュメントや個人情報を扱う業務でも安心して使えます。 - APIコスト不要:

クラウドの従量課金(トークン課金)を気にする必要がありません。

自分のPCの電力だけで動くので、何度でも試行錯誤し放題です。 - サクサク動く(低遅延):

インターネット通信の遅延がない(オフラインで動作する)ことや、モデル自体のサイズが小さいため、サクサク動きます。

ただし、ローカルで動くモデルは「SLM(小規模言語モデル)」と呼ばれる軽量なものが中心です。

クラウド上のLLM(GPT-5など)と比較すると、複雑な推論や膨大な知識を必要とするタスクは苦手な傾向にあります。

そのため、「まずはローカルで試作し、高度な処理が必要になったらクラウドへ」という使い分けが重要になります。

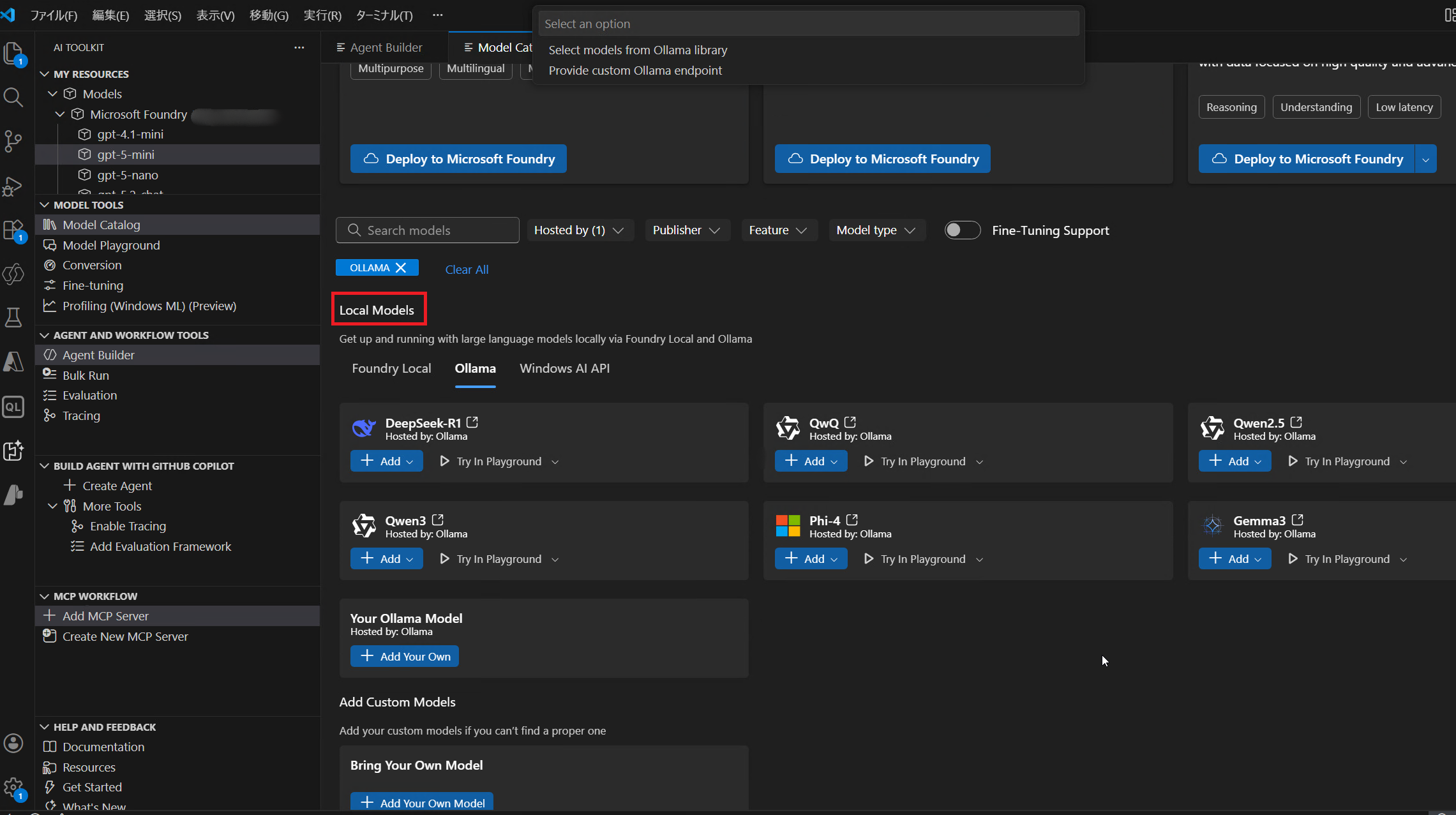

AI Toolkitを使えば、「Phi-4」や「Ollama」といったモデルを追加し、自分専用のアシスタントをすぐに作り始めることができます。

Playground機能:コードを書かずにAIを試す

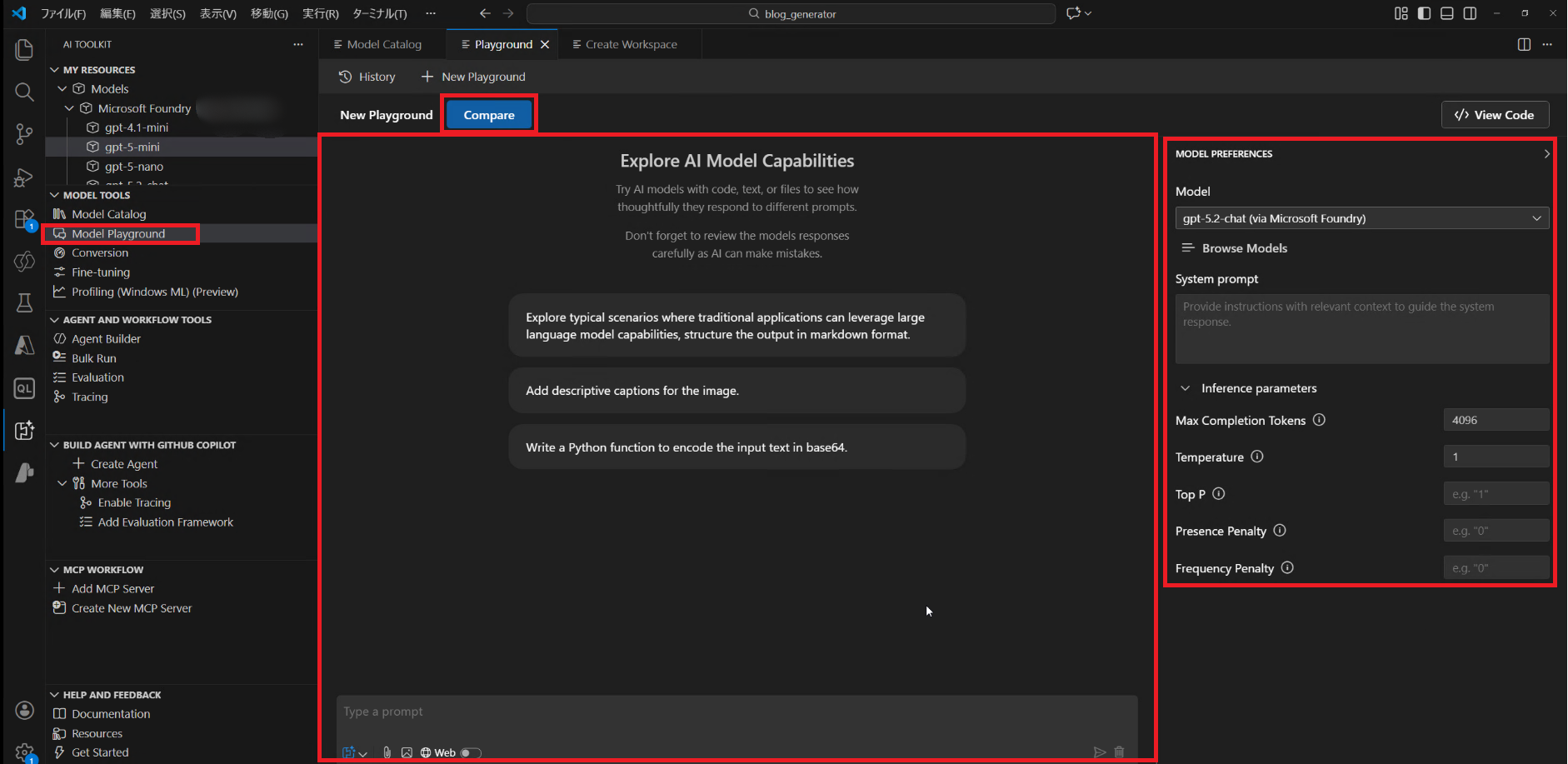

モデルをデプロイしたら、次に行うのが「Playground」でのテストです。

ここでは、チャット形式でAIの回答精度を確かめることができます。

私が「これは使いやすそうだな」と思ったのは、以下のポイントです。

- パラメータの微調整: Temperature(回答のランダム性)などを変えながら、回答の変化を一画面で確認できます。

- ローカル実行の簡単設定: 先ほど紹介したローカルモデルも、ここで選ぶだけでクラウドを経由せずにPC内で動かすことができます。

本格的にプログラムを書く前に、「このプロンプトで期待通りの答えが返ってくるか」を試行錯誤できるのは非常に効率的です。

モデルの比較(Compare機能)

さらに、画面上部の「Compare」を選択すると、2つのモデルを一画面で横並びに比較することができます。

以下のGIFでは、gpt-5-miniとgpt-5-nanoを比較してみました。

プロンプト:

次の語から同義語をまとめ、小文字化し、重複を除去して昇順ソート。

"ai","AI","生成ai","GenAI","機械学習","ML","ml"

出力はJSONのみ。{"keywords":["..."]}

モデルとしては、最軽量であるnanoの方が、回答が速いかと思いきや、miniの方が速かったです。

(mini:15秒ほど, nano:40秒弱)

今回のプロンプトは「同義語の解釈」や「JSONへの整形」という、AIにとって一定の「思考力」を要する内容だったため、「賢さとスピードのバランス」が取れている mini が実質的な処理速度で勝利したと考えられます。

この機能は非常に便利そうで、同じプロンプトに対して「モデルの違いによる回答内容の差」を確認できるだけでなく、「どちらが速く回答を生成できるか」も一目瞭然です。

クラウドモデルと軽量なローカルモデルを並べて、用途に応じた使い分けを検討する際などに重宝しそうです。

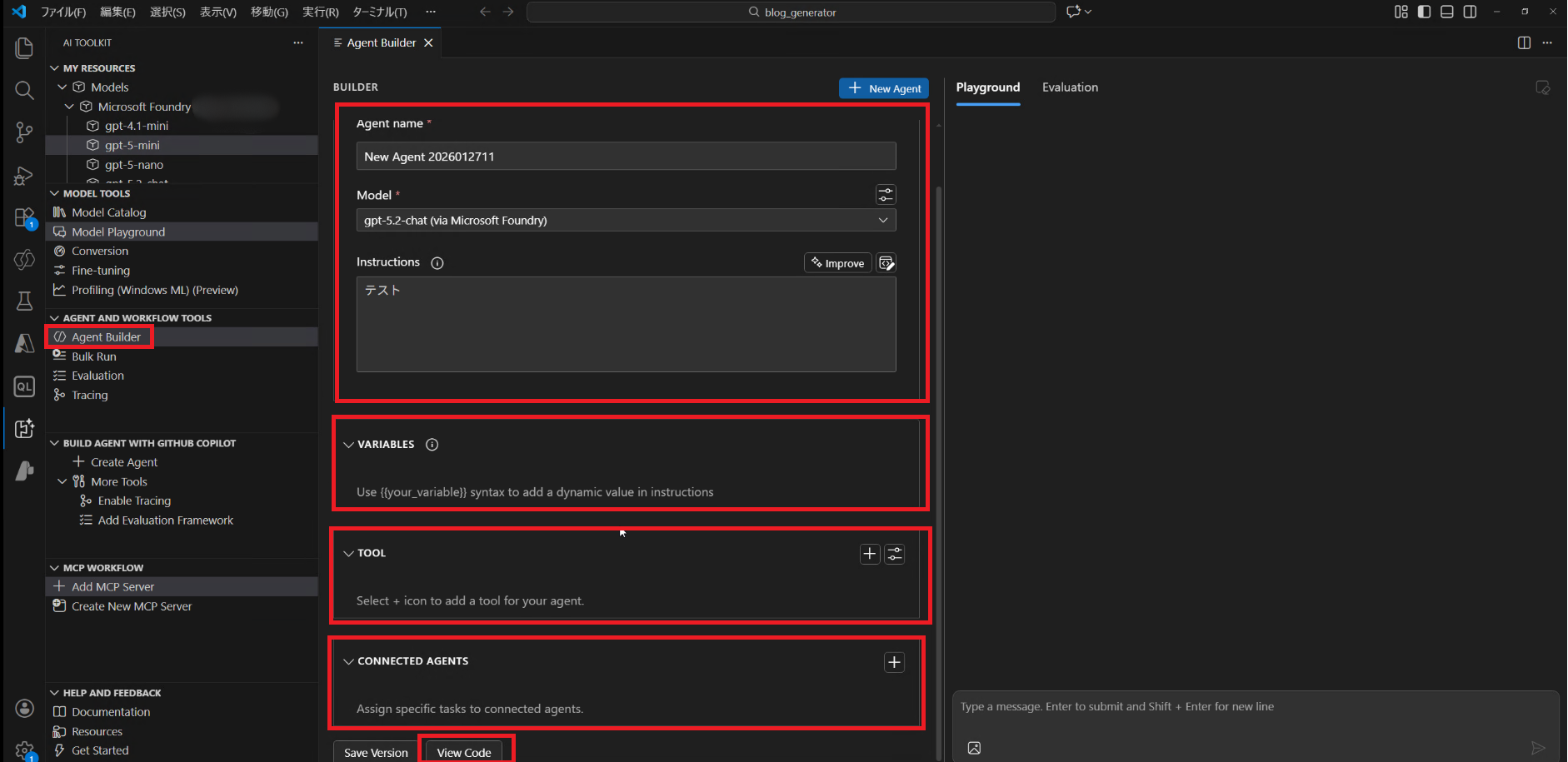

Agent Builder:一画面で完結するエージェント構築

Playgroundでモデルの挙動を確認したら、次はいよいよ「エージェント」の作成です。

左メニューの「Agent Builder」を選択すると、エージェント開発に必要な設定が一画面に集約されたUIが表示されます。

ここでは、単にプロンプトを入れるだけでなく、アプリケーションとして動作させるための高度な設定が可能です。

- 基本設定:

Agent Nameや使用するModel、Instructionsを定義します。 - VARIABLES(変数):

プロンプト内で動的に値を差し込むための変数を設定できます。 - TOOL(ツール):

MCP(Model Context Protocol)サーバーや外部サービスと連携し、エージェントに「データベース操作」や外部サービス操作などの機能を持たせることができます。 - CONNECTED AGENTS(連携エージェント):

他のエージェントと連携させる「マルチエージェント開発」の設定もここで行います。

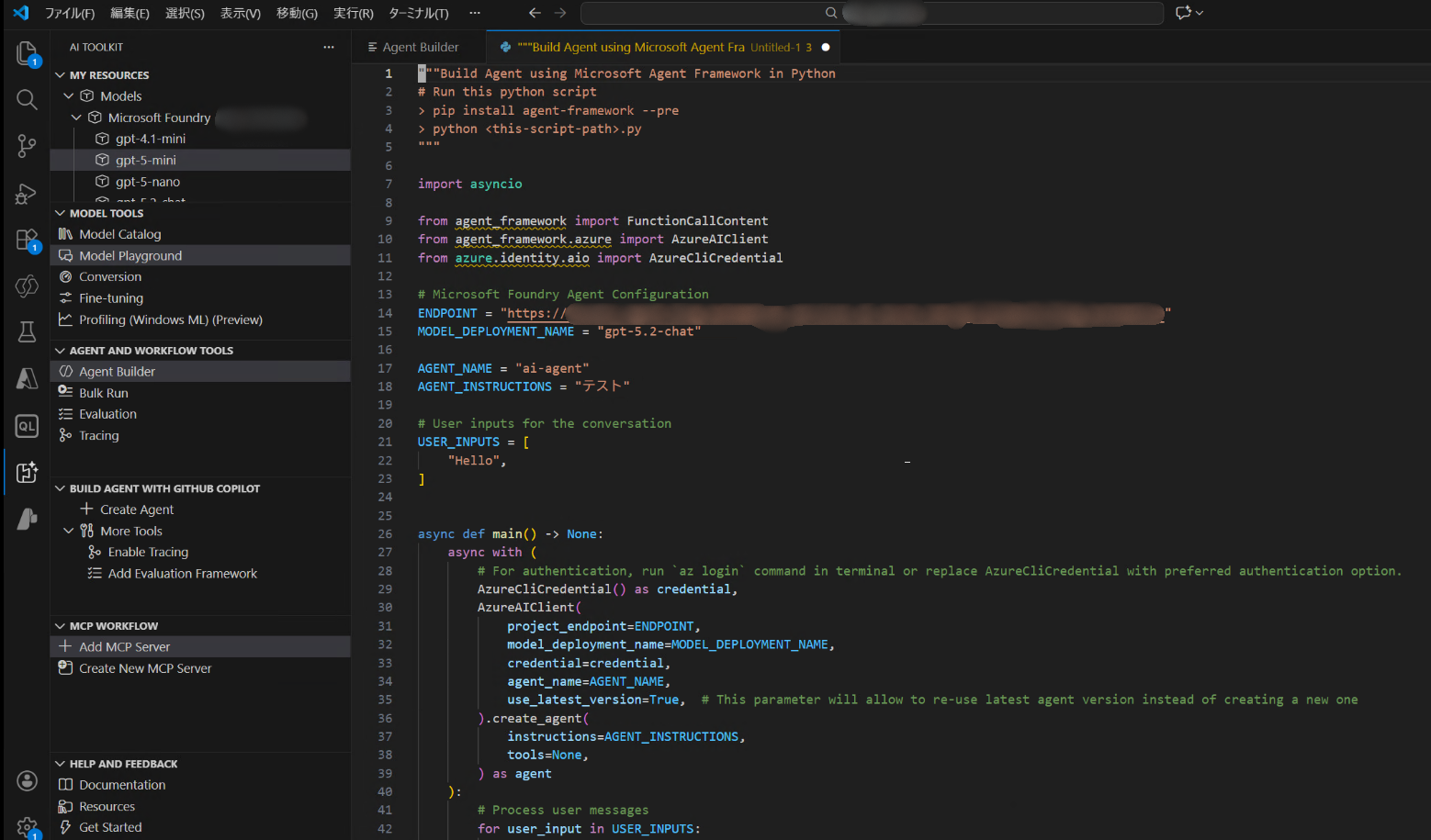

コードの自動生成(View Code)

そして、GUIでの設定が完了したら、画面下部にある「View Code」ボタンをクリックしてみてください。

このように、Agent Builderで設定した内容(モデル構成、プロンプト、ツール連携など)が、そのまま実行可能なプログラムコード(Python等)として生成されます。

「プロトタイプはノーコードで作り、実装はコードで行う」という流れがスムーズに行えるため、開発効率が大幅に向上しそうです。

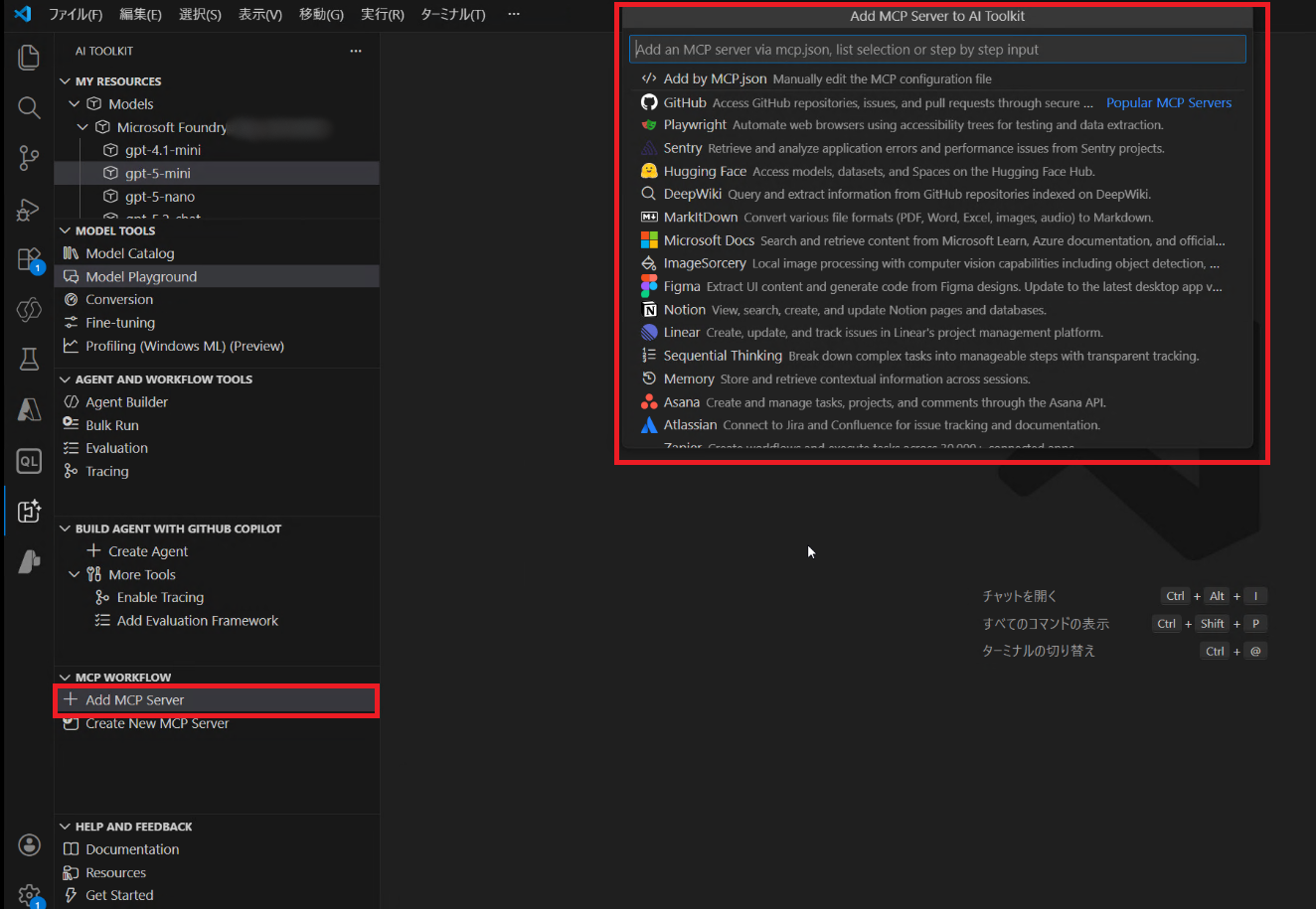

MCP Server:エージェントに「道具」を持たせる

先ほどのAgent Builderで触れた「TOOL」の部分を少し詳しく見てみましょう。

ここで重要な役割を果たすのが、最近話題のMCP(Model Context Protocol)です。

左メニュー下部の「Add MCP Server」を選択すると、エージェントに利用させたいMCPサーバーを追加・管理することができます。

ここでは、Microsoft等が提供する公式のMCPサーバーを選択して追加できるほか、自分で作成したカスタムMCPサーバーを登録することも可能です。

ここで追加したMCPサーバーは、Agent Builderの「TOOL」設定でエージェントに紐づけることができます。

これにより、AIは単に会話するだけでなく、「社内マニュアルを検索して回答する」「指定されたファイルを読み込んで要約する」といった、実用的なタスクをこなすエージェントへと進化します。

まとめ

AI Toolkit for Visual Studio Codeは、AI開発の「入口」から「実装」までを一本道につなげてくれるツールだと感じました。

私自身、まだすべての機能を使いこなしているわけではありませんが、、AIエージェント開発に活用していきたいと考えています。

VS Codeをお使いの方は、拡張機能メニューから「AI Toolkit」と検索して、そのカタログを眺めてみるだけでも面白い発見があるかもしれません。

最後までご覧いただき、ありがとうございました。

AI関連記事

筆者は他にも、AI関連をテーマとしたブログを公開しています。

興味がございましたら、こちらもあわせて、ぜひご覧ください。

QUICK E-Solutionsでは、各AIサービスを利用したシステム導入のお手伝いをしております。

それ以外でも QESでは様々なアプリケーションの開発・導入を行っております。提供するサービス・ソリューションにつきましては こちら に掲載しております。

システム開発・構築でお困りの問題や弊社が提供するサービス・ソリューションにご興味を抱かれましたら、ぜひ一度 お問い合わせ ください。

※このブログで参照されている、Microsoft、Microsoft Foundry、VS Codeは、米国およびその他の国におけるマイクロソフトの商標または登録商標です。

※その他、記載されている会社名および製品名は、各社の商標または登録商標です。