記事公開日

最終更新日

【Microsoft Ignite 2024】[セッションレポート] BRK117 | Lessons from Toyota for building durable multi-agent copilots

はじめに

こんにちは、DXソリューション営業本部 小出です。

シカゴで行われているMicrosoft Ignite 2024に参加しています。

現地からセッションレポートをお送りします。

まずは、今回一番印象に残ったトヨタ自動車のセッションをご紹介します。

Japan ProgramのWrap-upの中でも「Deep Dive Toyota Case study」で紹介されていました!

トヨタ自動車が耐久性のあるマルチエージェントAIシステムを構築して、車の設計と製造にどのように役立てたか、というセッションとなります。

ポイント

・O-beyaはトヨタ自動車が開発したマルチエージェントAIシステム

・技術ベースはAzure Open AI Service + CosmosDBのRAG構成

・エンジン、トランスミッション、バッテリー等の各専門分野用RAGを構築

・Durable Functionsが複数のエージェント(各専門分野用RAG環境)に振り分ける

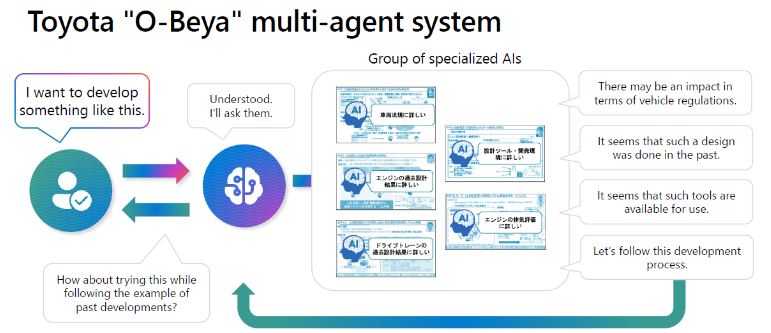

ちなみにO-Beyaとは、トヨタ自動車の「大部屋」制度をAI化したシステムです。

「大部屋」制度とはトヨタ自動車が長年取り入れてきた制度で、エンジニアやスタッフが一つの大きな部屋で共同作業を行い、コミュニケーションと情報共有を促進してプロジェクトの効率と生産性を高める手法です。

セッションスピーカー

・大西健二氏 トヨタ自動車 Sr.Manager, Powertrain Function & Performance Development Dept.

・宮坂航亮氏 日本マイクロソフト Azure App Innovation Specialist

・Marco Casalaina Azure AI VP Products

・Mark Brown Azure Cosmos DB Principal PM Manager

アジェンダ

・Introduction: Toyota challenges and the "O-Beya" system

・Multi-agent system architecture

・What's new in Azure AI?

・What's new in Azure Cosmos DB?

Introduction: Toyota challenges and the "O-Beya" system

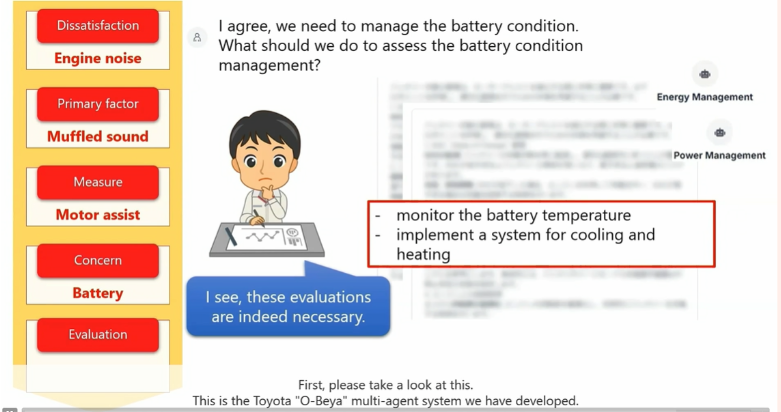

まずは、O-Beya System (Toyota Multi-Agent AI System) のデモがありました。

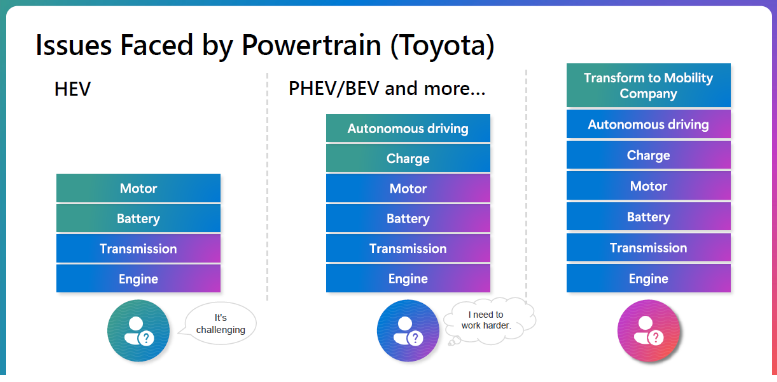

当初車にはエンジンとトランスミッションしかありませんでしたが、ハイブリッド車や自動運転が追加されてより複雑になり、エンジニアの負担が大きくなっています。

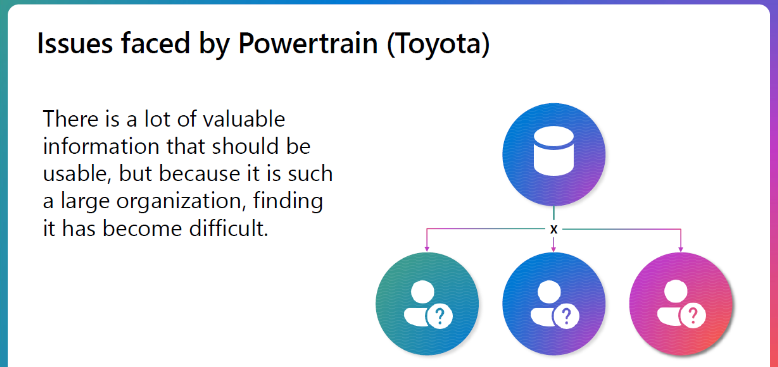

課題は、活用できる貴重な情報がたくさんあるのに組織が大きいため、見つけるのが難しくなっていることでした。

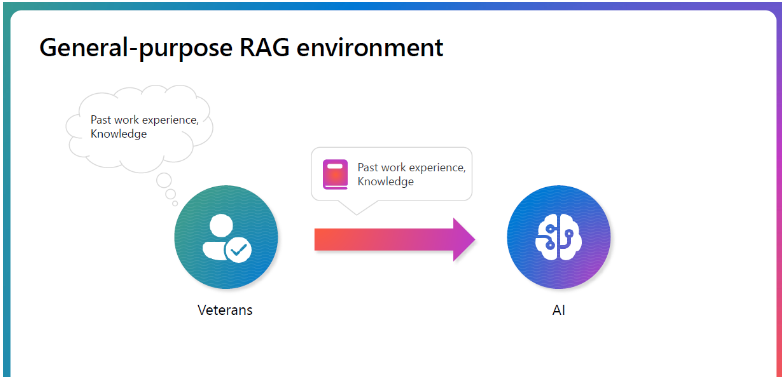

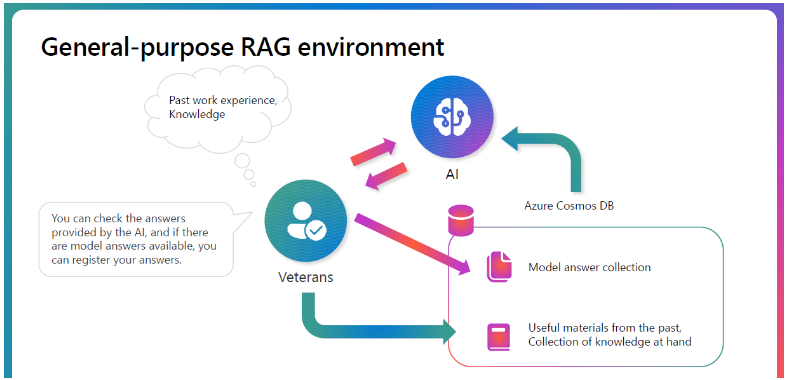

各分野に特化したRAGを構築することにより、ベテランエンジニアに代わるAIの作成を検討しました。

ベテランエンジニアは、AIによる回答を確認し、必要に応じて回答集を作成します。このように高品質の回答データを蓄積することにより、有用なAIとなります。

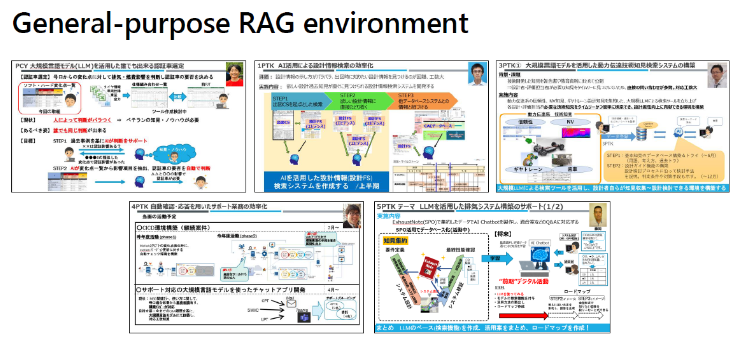

この汎用RAGシステムは会社に広く導入されました。フェローは汎用RAGを作る活動に取り組んでいます。構築した汎用RAGの数は約30になります。

大きな会議室にベテランエンジニアを集めた、と想定したAIシステムの開発に着手しました。下記が”O-Beya” multi-agent systemの概要図です。マルチエージェントが質問内容に応じて各エージェント(汎用RAG)に振り分けます。

Multi-agent system architecture

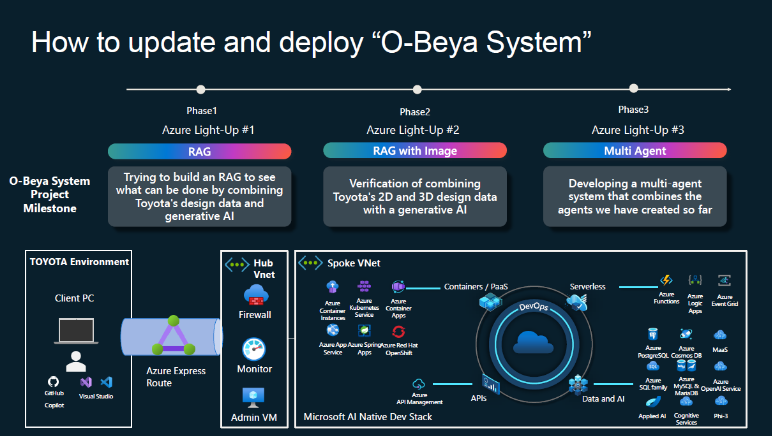

本プロジェクトは大きく分けて3つのフェーズに分かれていました。

・フェーズ1 RAGの構築

・フェーズ2 RAGに画像データの組み込み

・フェーズ3 マルチエージェント構成の開発

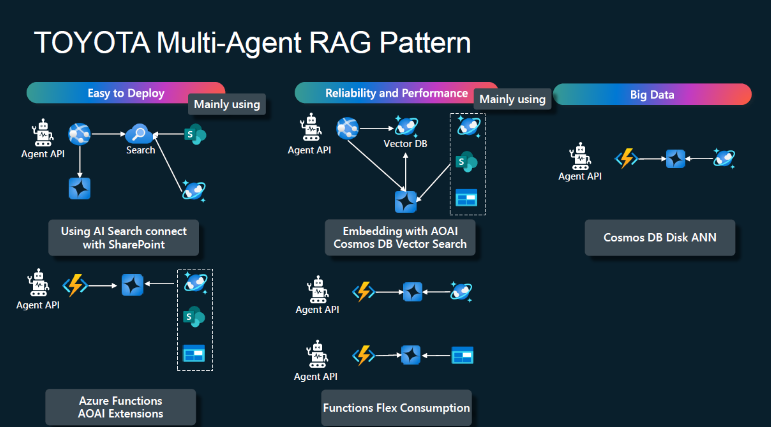

さまざまなRAG(Retrieval-Augmented Generation)のパターンを評価しました。

・1番目のパターン

AI SearchとSharePointを使用して構築しました。このパターンは、データの多くがSharePointに保存されていることから、基本的なRAGアーキテクチャとして選ばれました。

・2番目のパターン

AOAI(Azure OpenAI Service)の拡張機能とAzure Functionsを利用し、簡単なサーバーレス構成で迅速なプロトタイプ開発が可能です。どちらも開発が容易でした。

・3番目のパターン

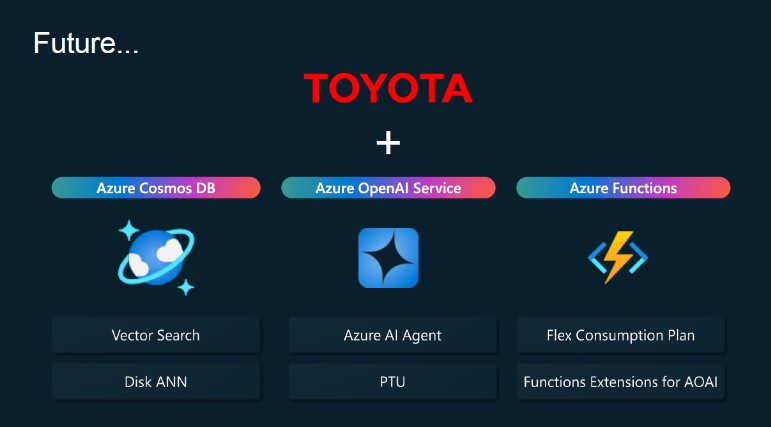

CosmosDBのベクトル検索機能を活用しています。このパターンでは、ナレッジデータベースが拡大しても自動スケーリングによる高いパフォーマンスを得られる点が利点です。

・4番目のパターン

Functions Flex Consumptionを活用してコスト最適化を図ります。3番目と4番目のパターンは、信頼性やパフォーマンスが重要な場合に選択されます。

・5番目のパターン

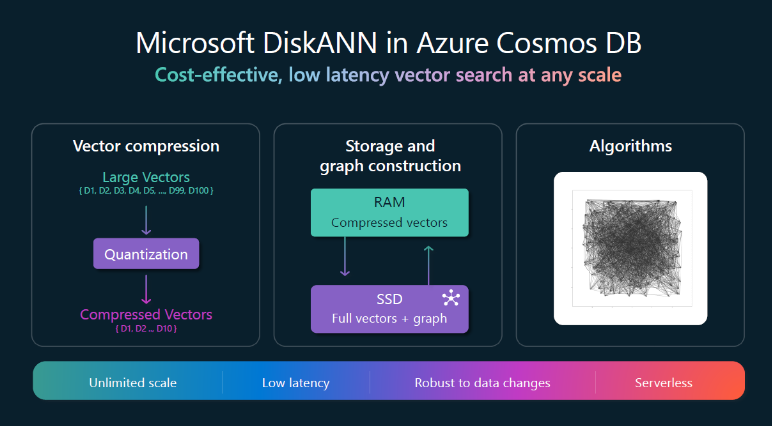

エージェントの実装のためにディスクANN(Approximate Nearest Neighbor)をCosmosDBに統合します。このパターンはまだ導入されていませんが、データ規模が大きい場合には必要となります。

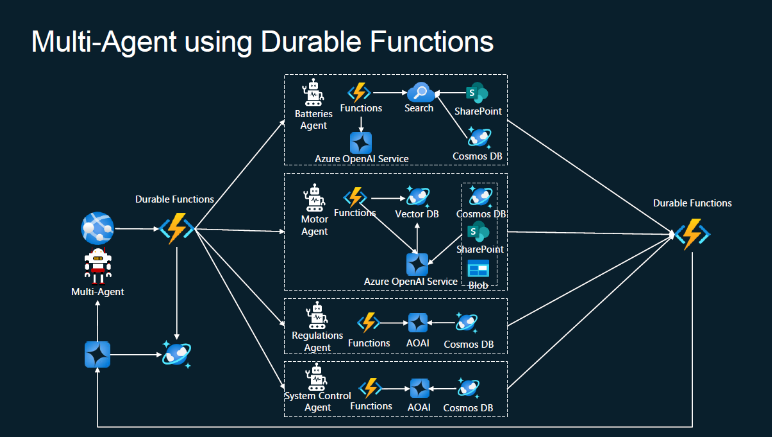

マルチエージェントシステムには4つの異なるエージェントが含まれており、各エージェントのプロンプトは定義されています。

Durable Functionsを採用した理由は以下の3つです。

・エージェント間の並列処理が可能になりパフォーマンスが向上

・エラー処理やリトライなどのワークフローをサポート

・外部に状態を保存することで監視が容易になること

エージェントは非同期で並列動作するため、容易にエージェントの追加が可能なアーキテクチャになっています。

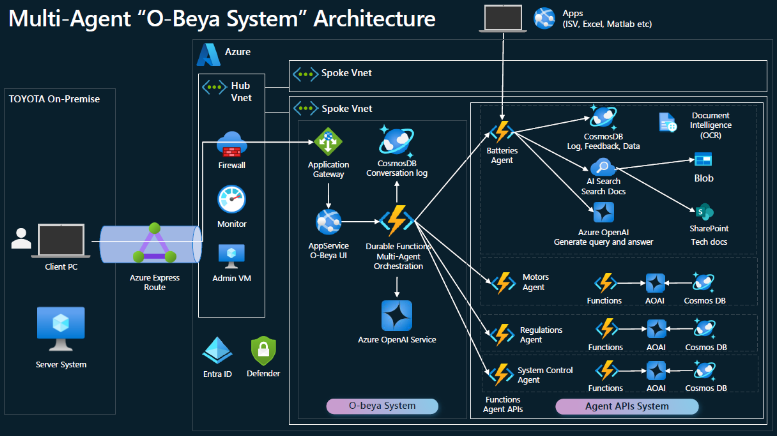

システムの全体アーキテクチャです。

質問と回答はCosmosDBに記録され、不適切なコンテンツを監視することが出来ます。

今後は、今回発表されたアップデート(DiskANN、Azure AI Agent)を活用して、製造業の先駆的なユースケースを作っていく予定とのことです。トヨタ自動車さんの今後に期待しましょう!

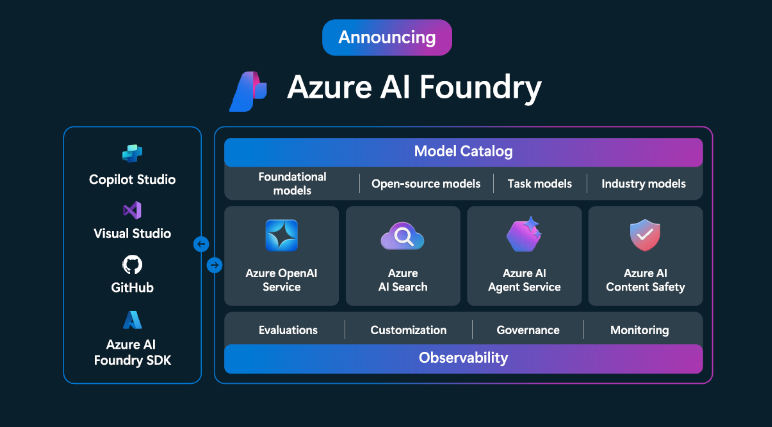

What's new in Azure AI?

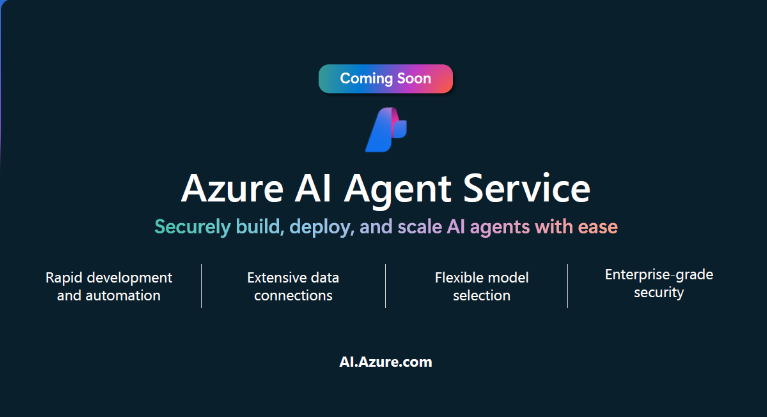

Azure AI Agentサービスの紹介がありました。

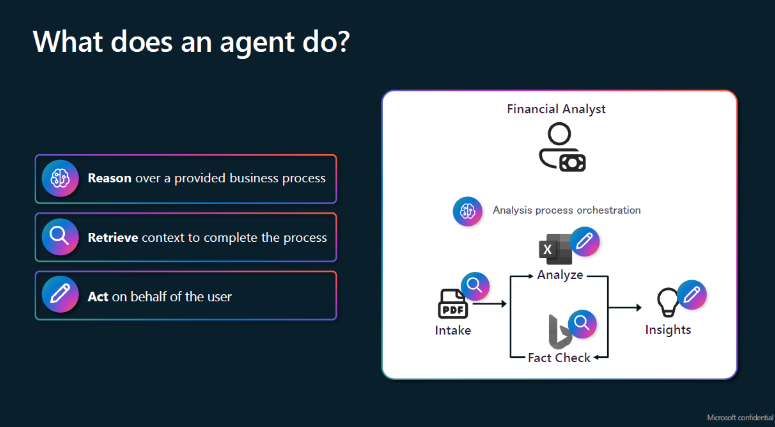

エージェントとは、1つ以上のモデルの上にあるフレームワークであり、複雑で実行時間の長い操作を実行し、ユーザーに代わってアクションを実行できます。

What's new in Azure Cosmos DB?

DiskANNはMicrosoft Researchによって開発されたMicrosoftのベクトルインデックス作成および検索アルゴリズムで、軽量のメモリ内ベクトルストアとディスクに格納されたベクトルグラフを組み合わせたものです。

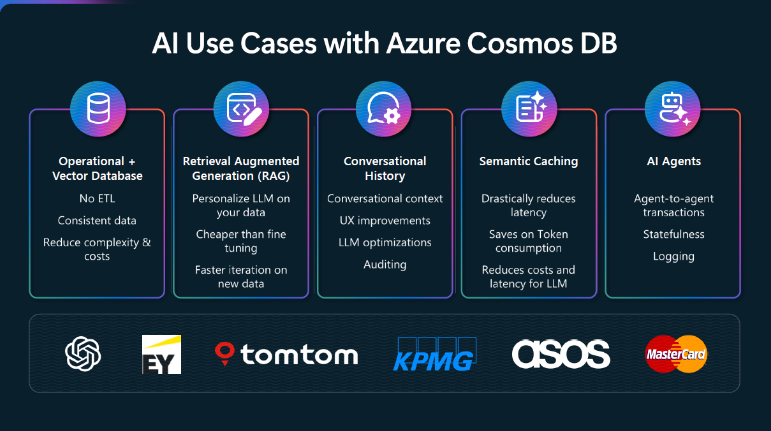

さまざまなユースケースに活用出来ます。

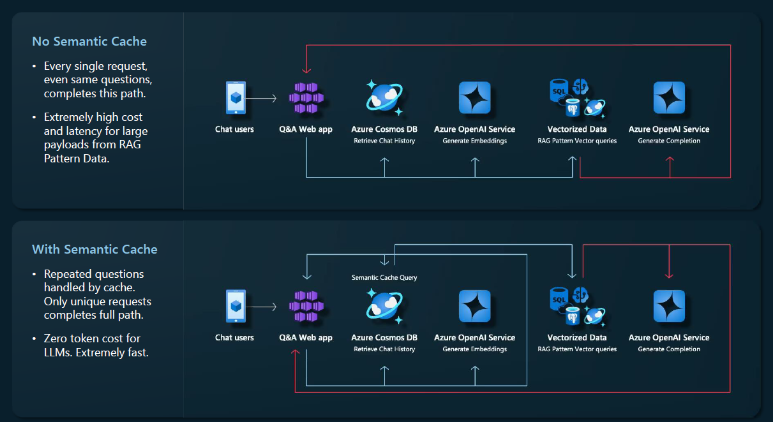

セマンティックキャッシュを活用することで、以下の効果が得られます:

・トークン消費の削減:繰り返しの質問に対してキャッシュが応答を提供するため、不要な処理を削減します。

・レスポンス時間の短縮:キャッシュの利用により、高速な応答が可能になります。

同じ質問を何度も繰り返してくる顧客がいる顧客向けアプリケーションでは特に有効です。

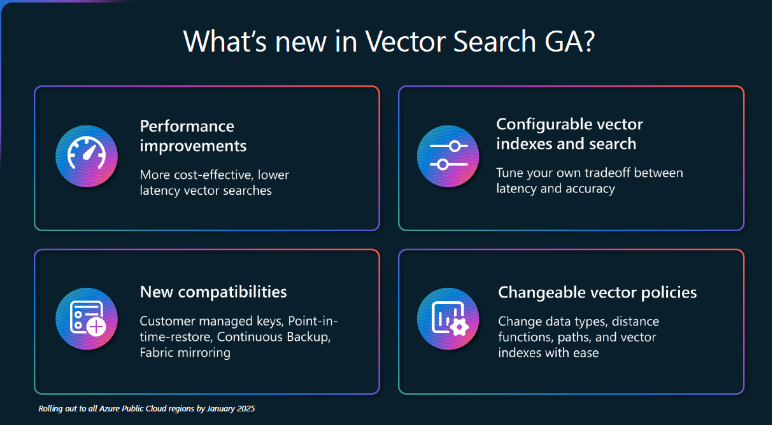

Vector SearchとDiskANN Vector IndexがGAになりました。

これらの新機能により、ベクトル検索の精度、効率、セキュリティ、そして運用の柔軟性が大幅に改善されています。これにより、リアルタイム検索が必要なアプリケーションや、データセキュリティが重要なユースケースにおいて、さらに強力なソリューションを提供できるようになります。Azure Public Cloudの全リージョンで2025年1月までに展開される予定です。

以下のパブリックプレビューがリリースされました:

・全文検索とランキング(BM25)

高度なテキスト検索機能が提供されることで、BM25を使用した検索結果の関連性が向上します。これにより、アプリケーションにおける検索体験がさらに強化されます。

・ハイブリッド検索

ベクトル検索と全文検索を組み合わせて実行し、それらの結果をランク付けすることで、アプリケーション内のデータ関連性をさらに高めることが可能になります。

資料リンク

セッション動画、資料は公開済みです。リンクは以下となります。

https://ignite.microsoft.com/en-US/sessions/BRK117?source=sessions

まとめ

今回のトヨタ自動車さんの事例は、今後間違いなくマルチエージェントRAGの代表的なユースケースになると思います。

多くの会社がマルチエージェントRAGのユースケースを共有し、ブラッシュアップしていければいいなと思っています。

ここ数年で、ほとんどの企業にマルチエージェントRAGが導入され、全社員が普通にRAGを業務に活用する時代が来るのではないでしょうか?

※このブログで参照されている、Microsoft、Azure OpenAI、その他のマイクロソフト製品およびサービスは、米国およびその他の国におけるマイクロソフトの商標または登録商標です。

※その他の会社名、製品名は各社の登録商標または商標です。